快科技6月16日消息,近日,韩国高级科学技术院(KAIST)、TB级互联与封装实验室(TERA)共同展望了未来十年HBM高带宽内存、AI GPU加速卡的发展形势,疯狂得有些难以置信。HBM技术目前已落地最先进的是HBM3E,NV B300系列、AMD MI350系列都做到了最大288GB。即将到来的是BHM4,NVIDIA Rubin系列预计做到最大384GB,AMD MI400系列更是准备冲击432GB。

AI GPU加速卡功耗失控!10年内超过15000W

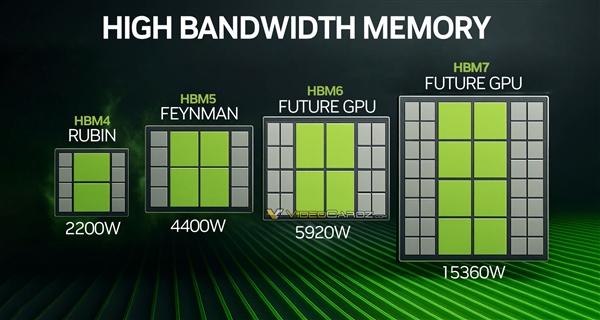

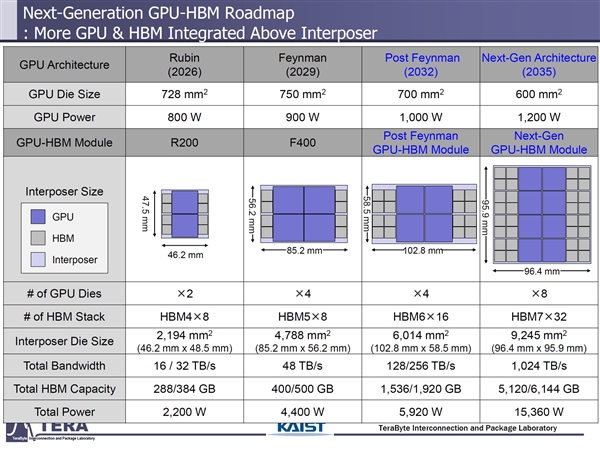

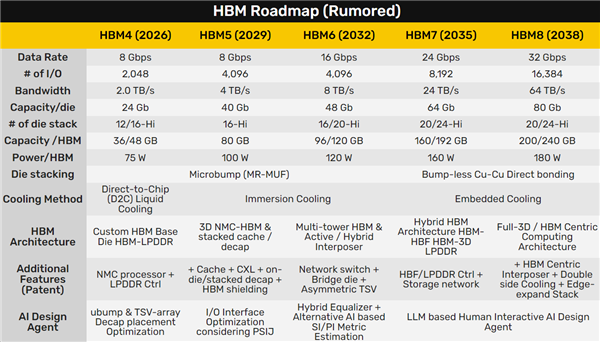

后续标准尚未制定,但是预计HBM5的容量可达400-500GB,HBM6能够做到1536-1920GB(1.5-1.9TB),HBM7更是可达5120-6144GB,也就是大约4.2-6TB!NVIDIA Rubin预计明年推出,芯片面积728平方毫米,芯片功耗800W,双芯整合封装,中介层面积近2200平方毫米,搭配8颗HBM4,带宽最高32TB/s,整卡功耗预计2200W。目前的AMD MI350系列风冷1000W、水冷1400W,NVIDIA B300也做到了1400W。再往后,代号Feyman的再下一代NVIDIA AI GPU预计2029年到来,估计核心面积750平方毫米左右,芯片功耗就有900W左右,四芯整合封装,中介层面积约4800平方毫米,搭配8颗HBM5,带宽48TB/s,整卡功耗4400W。

AI GPU加速卡功耗失控!10年内超过15000W

AI GPU加速卡功耗失控!10年内超过15000W

之后的代号都没公布,以下数据也都是纯粹的想象:

Feyman之后下一代2032年推出,单芯片面积缩小到700平方毫米,但是功耗突破1000W,而且通过四芯整合封装,中介层超过6000平方毫米,搭配多达16颗HBM6,带宽256TB/s,整卡巩固好近6000W。再往后的2035年,又是新一代,单芯片面积继续缩小到600平方毫米,但是功耗达1200W,而且首次八芯片整合封装,中介层超过9000平方毫米,搭配32颗HBM7,带宽1TB/s,功耗15000W!这么走下去真的好吗?每个数据中心旁边就得搭配一座核电站了!

AI GPU加速卡功耗失控!10年内超过15000W

【本文结束】出处:快科技

- 本文固定链接: https://x86android.com/articles/61793.html

- 转载请注明: zhiyongz 于 安卓中文站 发表

《本文》有 0 条评论